엔비디아, 구글 이어 아마존까지 뛰어든 AI 가속기.. 인공지능 시대 이끈다

동아닷컴

입력 2019-02-08 15:24 수정 2019-02-08 16:04

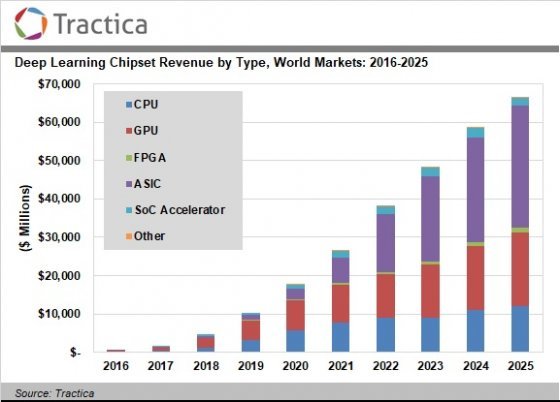

크게 메모리(데이터 저장장치)와 비메모리(CPU, GPU, DSP, 컨트롤러 등)로 나눌 수 있었던 반도체 업계에 인공지능 가속기(AI accelerator, 이하 AI 가속기)라는 새로운 형태의 반도체가 등장해 그 세를 넓히고 있다. 인텔, 엔비디아, 구글, 아마존 등 내로라하는 해외 IT 기업뿐만 아니라 네이버, 퓨리오사AI 등 국내 기업과 스타트업도 인공지능 시장에서 패권을 쥐기 위해 AI 가속기 개발 및 상용화에 나섰다. 미국의 시장조사기관 트랙티카는 2017년 16억 달러에 불과하던 AI 가속기 시장이 매년 크게 성장해 2025년에는 663억 달러에 달하는 거대 시장으로 거듭날 것으로 예상했다.

AI 가속기 시장규모 예측도, 출처: 트랙티카

AI 가속기 시장규모 예측도, 출처: 트랙티카AI 가속기란 이름 그대로 인공지능을 구현하고 실행하기 위한 전용 하드웨어를 뜻한다. 2010년대에 들어 초기 인공지능이 등장했을 당시에는 CPU, GPU, 메모리 등 범용 컴퓨터 부품을 이용해 인공지능을 구현했으나, 점점 인공지능만을 위한 독자적인 하드웨어의 필요성이 제기되어 관련 연구가 활발해졌다. 현재는 기계학습(머신러닝), 인공신경망(딥러닝) 등 소프트웨어적인 영역과 함께 하드웨어로서 인공지능 산업의 한축을 담당하고 있다.

AI 가속기의 또 다른 이름은 '인공신경망 칩셋(Deep learning chipsets)'이다. 현재 인공지능에 필수 기술인 인공신경망을 효과적으로 구현하는데 초점을 맞춰 설계되는 하드웨어이기 때문이다.

역사가 짧은 만큼 AI 가속기에 표준은 아직 없다. CPU(중앙처리장치), GPU(그래픽처리장치) 등 기존 컴퓨터 하드웨어 형태를 취하는 경우도 있고, FPGA(용도변경이 가능한 반도체)나 ASIC(주문형 반도체)처럼 전용 하드웨어인 경우도 있다. 심지어 모바일 프로세서(SoC) 형태를 취한 AI 가속기도 있다.

현재 업계 주류는 GPU 기반의 AI 가속기다. 특정 연산에 최적화된 수많은 코어를 품고 있는 GPU의 기본 구조가 인공신경망을 구현하는데 유리하기 때문이다. GPU 기반의 AI 가속기는 인공지능 훈련(학습)과 추론(실행)을 모두 수행할 수 있어, 현재 거의 대부분의 인공지능은 GPU 기반의 AI 가속기로 만들어져서 실행되고 있다고 해도 과언이 아니다.

GPU 기반의 AI 가속기는 주로 엔비디아, AMD 등 기존 GPU 업체들이 집중 연구하고 있다. 엔비디아와 AMD의 경우 GPU에서 그래픽 출력 능력을 제거하고, 대신 연산처리 능력만 극대화시킨 GPGPU(일반목적용 GPU)라는 AI 가속기를 시장에 선보였다. 원래 GPGPU는 암호해독이나 다중연산 등에 특화된 기기였지만, 인공신경망 구현에도 큰 도움을 준다는 사실이 밝혀져 그 수요가 급격히 늘어났다. 현재 엔비디아는 테슬라, AMD는 라데온 인스팅트라는 브랜드로 AI 가속기를 판매 중이다.

엔비디아 테슬라 V100, 출처: IT동아

엔비디아 테슬라 V100, 출처: IT동아CPU 기반의 AI 가속기는 CPU 업계의 강자인 인텔이 주로 연구하고 있다. 과거 서버용 프로세서인 제온을 인공신경망 구현에 맞게 최적화해 '제온 파이'라는 AI 가속기를 선보인 바 있다. 하지만 엔비디아의 GPGPU에 밀려 시장에서 큰 힘을 쓰지 못했다. 이에 인텔은 2016년 미국의 AI 가속기 개발사인 '너바나'를 인수해 기존 CPU와 별개의 아키텍처(구조도)로 설계된 너바나 NNP(뉴럴 네트워크 프로세서)라는 AI 가속기를 선보이고, 해당 하드웨어를 페이스북에게 제공해 인공지능 구현 능력을 테스트하는 등 관련 시장 공략을 서두르고 있다.

현재는 GPU 기반의 AI 가속기가 시장을 주도하고 있지만 2022년 이후 부터는 ASIC이 AI 가속기 시장의 대세로 떠오를 전망이다. 기존 기술을 재활용하기 위해 어딘가 최적화되지 않은 부분이 있는 GPU, CPU와 달리 ASIC은 처음부터 인공신경망 구현에 최적화되어 설계되기 때문이다. 특히 GPU 기반 AI 가속기와 비교해 전력소모가 매우 적어 친환경 데이터센터 구현에 많은 도움을 주는 것으로 알려졌다.

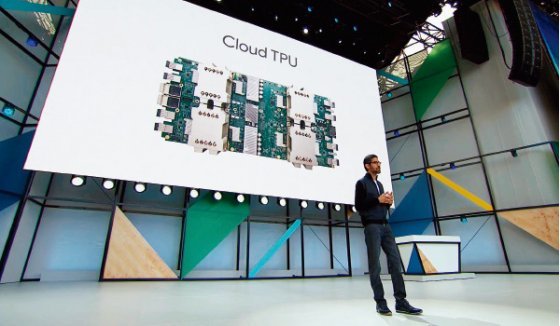

ASIC 형태의 AI 가속기 가운데 가장 유명한 것이 바로 구글의 TPU(텐서플로유닛)다. TPU는 인공신경망 기술 가운데 가장 널리 이용되는 오픈소스 프레임워크인 '텐서플로'를 구현하는데 최적화된 하드웨어다. 구글이 직접 설계한 이 AI 가속기는 기존 ASIC 형태의 AI 가속기가 인공지능 추론용으로만 이용할 수 있고, 훈련용으로 이용할 수 없다는 단점마저 극복했다.

\'구글I/O 2017\'에서 차세대 인공지능 전용 칩 \'TPU\'를 발표하는 모습, 출처: 구글

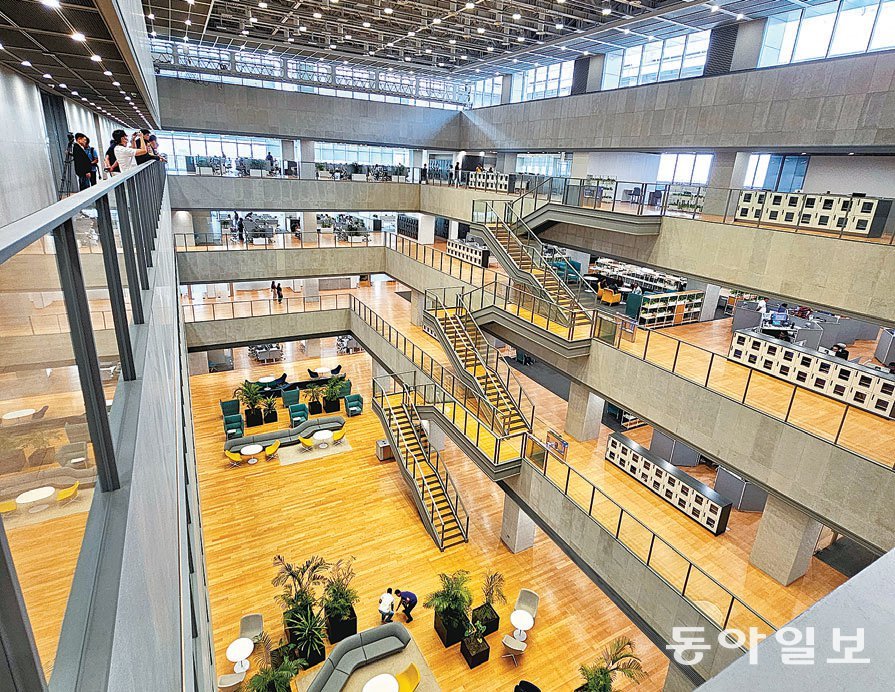

\'구글I/O 2017\'에서 차세대 인공지능 전용 칩 \'TPU\'를 발표하는 모습, 출처: 구글아마존 역시 이스라엘의 AI 스타트업을 인수해 사내에 '안나푸르나'라는 관련 개발팀을 만든 후 '인프렌시아'라는 AI 가속기를 자체 개발해 선보였다. 인프렌시아는 아직 인공지능 추론용으로만 이용할 수 있고 훈련용으로 이용할 수는 없지만, 기술이 고도화되면 TPU처럼 훈련용으로도 이용할 수 있게 될 전망이다. 네이버가 투자한 AI 스타트업 퓨리오사AI 역시 구글, 아마존처럼 ASIC 형태의 AI 가속기를 개발하고 있다. 네이버는 퓨리오사AI가 개발한 AI 가속기를 자사 데이터센터에 투입해 자사 클라우드 서비스 경쟁력 강화에 활용할 계획이다.

모빌아이의 얘기도 빼놓을 수 없다. 자율주행차를 연구하는 이스라엘의 기업 모빌아이는 자율주행차 구현을 위해 자체 개발한 AI 가속기 '아이큐(EyeQ)'를 아우디, 닛산 등 전 세계 자동차 업체들에게 공급하고 있다. 엄밀히 분류하자면 아이큐 역시 컴퓨터 비전(보는능력) 구현에 특화된 ASIC 형태의 AI 가속기다.

대부분의 AI 가속기는 클라우드 서비스 업체의 대규모 데이터센터에 공급되어 클라우드를 통해 기업이나 개발자들에게 제공되고 있다. 기업 입장에서 AI 가속기를 포함한 컴퓨팅 인프라를 직접 갖추는 것보다 필요할 때 빌려쓰는 것이 시간이나 가격적인 면에서 더 유리하기 때문이다. 대부분의 인공지능이 이러한 대규모 클라우드 데이터센터에서 개발되어 실행되고 있다.

하지만 모든 작업을 중앙 인공지능에 기대지 않고 말단(Edge) 단말기에서 소규모 인공지능을 구현해 자잘한 작업을 처리하는 엣지 컴퓨팅이 각광받으면서, 모바일 프로세서 형태의 AI 가속기를 개발하려는 움직임도 점점 활발해지고 있다. 애플,퀄컴, 화웨이, 구글 등은 자사의 모바일 프로세서에 AI 가속용 코어를 추가하거나 별도의 초소형 AI 가속기를 스마트폰이나 태블릿 PC에 별도 탑재하는 식으로 대응하고 있다. 스마트폰, 태블릿PC에 탑재된 AI 가속기는 주로 이미지를 분석해 사진의 품질을 향상시키는데 활용하고 있다.

향후에는 사물인터넷 기기에도 초소형 AI 가속기가 탑재될 것으로 기대받고 있다. 개별 기기에 인공지능과 AI 가속기를 탑재함으로써 스마트홈이나 스마트 팩토리를 더욱 효율적으로 구현할 것으로 기대받고 있다. 작년 구글은 엣지 TPU라는 초소형 AI 가속기를 선보이며 스마트홈과 팩토리 시장을 적극 공략할 것임을 밝힌 바 있다.

한 업계 관계자는 "인공지능 시대가 열리면서 전 세계의 모든 IT 기업이 AI 가속기 개발에 뛰어들었다고 해도 과언이 아니다"며, "국내 반도체 기업들도 메모리, 컨트롤러 뿐만 아니라 AI 가속기 개발 등으로 사업 영역을 확대해야 인공지능 하드웨어 시장에서 뒤쳐지지 않고 경쟁력을 확보할 수 있을 것"이라고 분석했다.

동아닷컴 IT전문 강일용 기자 zero@donga.com

비즈N 탑기사

김숙 “내 건물서 거주+월세 수입 생활이 로망”

김숙 “내 건물서 거주+월세 수입 생활이 로망” “20억 받으면서 봉사라고?”…홍명보 감독 발언에 누리꾼 ‘부글’

“20억 받으면서 봉사라고?”…홍명보 감독 발언에 누리꾼 ‘부글’ 세계적 유명 모델이 왜 삼성역·편의점에…“사랑해요 서울” 인증샷

세계적 유명 모델이 왜 삼성역·편의점에…“사랑해요 서울” 인증샷 “사람 치아 나왔다” 5000원짜리 고기 월병 먹던 中여성 ‘경악’

“사람 치아 나왔다” 5000원짜리 고기 월병 먹던 中여성 ‘경악’ “모자로 안가려지네”…박보영, 청순한 미모로 힐링 여행

“모자로 안가려지네”…박보영, 청순한 미모로 힐링 여행- 엄마 편의점 간 사이 ‘탕’…차에 둔 권총 만진 8살 사망

- 8시간 후 자수한 음주 뺑소니 가해자…한문철 “괘씸죄 적용해야”

- 교보생명, 광화문글판 가을편 새단장…윤동주 ‘자화상’

- 힐러리 “내가 못 깬 유리천장, 해리스가 깨뜨릴 것”

- ‘SNS 적극 활동’ 고현정…“너무 자주 올려 지겨우시실까봐 걱정”

전기 흐르는 피부 패치로 슈퍼박테리아 막는다

전기 흐르는 피부 패치로 슈퍼박테리아 막는다 강력 대출규제에… 서울 9억∼30억 아파트 거래 대폭 줄었다

강력 대출규제에… 서울 9억∼30억 아파트 거래 대폭 줄었다 美, 칩스법 대상 태양광까지 확대… 中 글로벌 시장 장악 견제

美, 칩스법 대상 태양광까지 확대… 中 글로벌 시장 장악 견제 [단독]금융권 전산장애 피해액 5년간 350억… “행정망 오류 책임 커”

[단독]금융권 전산장애 피해액 5년간 350억… “행정망 오류 책임 커” MZ세대 팀워크 기피증?… ‘학습 지향성’으로 극복

MZ세대 팀워크 기피증?… ‘학습 지향성’으로 극복- 정의선 현대차그룹 회장 “‘아키오 도요타’ 가장 존경하는 분”

- [머니 컨설팅]금리 인하기, 상업용 부동산 투자 주목해야

- 주도주 없는 증시, ‘경영권 분쟁’이 테마주로… 급등락 주의보

- 금값, 올들어 33% 치솟아… 내년 3000달러 넘을 수도

- [단독]배달주문 30% 늘때 수수료 3배로 뛰어… “배달영업 포기”

![[단독]올해 서울 입주아파트 18곳 중 16곳 유해물질 기준치 초과 [단독]올해 서울 입주아파트 18곳 중 16곳 유해물질 기준치 초과](https://dimg.donga.com/a/102/54/90/1/wps/ECONOMY/FEED/BIZN_REALESTATE/130326015.2.thumb.jpg)